Il y a quelques jours, le journal Les Echos offrait une tribune libre à Jeffrey Sachs, intitulée « Les données, une nouvelle arme contre la pauvreté ». L’économiste américain, directeur de l’Institut de la Terre de l’Université de Columbia et consultant spécial du Secrétaire Général des Nations Unies, Ban Ki-moon, commence fort en affirmant :

Avec de faibles investissements, cette massification des données pourrait également conduire à une révolution du développement durable. Et accélérer les progrès vers l’éradication de la pauvreté, en favorisant l’intégration sociale et la protection de l’environnement.

Sachs détaille les nombreux bienfaits liés au Big Data, qui « révolutionne déjà » la fourniture et la gestion des prestations de services par les gouvernements et les entreprises, et qui permet « à l’opinion publique d’identifier les problèmes et de tenir les institutions publiques et les entreprises pour responsables ». Il lui attribue enfin un dernier objectif : « permettre à l’opinion publique de savoir si oui ou non un objectif mondial est réellement atteint ». Evoquant les objectifs du programme Millénium de l’ONU, dont il est l’instigateur et le directeur, il évoque le manque de connaissances précises pour savoir s’ils ont été atteints, « en raison de l’absence de données de haute qualité, en temps opportun » et estime que « la révolution des données peut mettre fin à des longs délais et améliorer considérablement la qualité de ces données ».

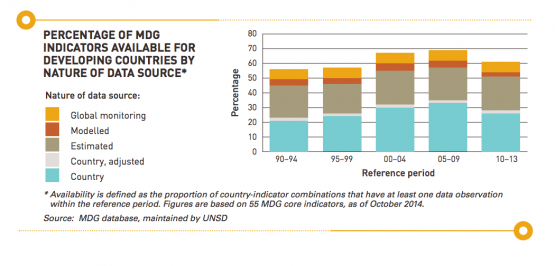

De façon peu surprenante, Jeffrey Sachs nous offre ici une vision complètement angélique du Big Data. De fait, il prêche pour sa paroisse. En fait, il semble que la majeure partie des objectifs fixés dans le cadre du programme Millénium ne soient pas mesurables. Ainsi, cité dans le Financial Times, un rapport de l’ONU estime que moins de 60% des données permettant cette évaluation sont disponibles dans les pays émergeants (cf. graphe ci-dessous), et ce malgré « d’énormes investissements ». Mieux encore, seulement la moitié de ces données est fournie par les pays eux-mêmes, l’autre moitié étant estimée. Difficile, dans ces conditions, de justifier de la réussite d’un programme dont même le Secrétaire Général de l’ONU reconnaît l’insuffisance des avancées.

Ce n’est évidemment pas la première fois qu’est évoqué le recours au Big Data pour les problématiques liées au développement – l’ONU y a même dédié un programme, Global Pulse. Mais il est étonnant que le très sérieux journal Les Echos n’ait pas apporté de contrepoint à la vision de Jeffrey Sachs. Ils auraient, par exemple, pu faire appel au statisticien français Emmanuel Letouzé, fondateur du think tank Data-Pop Alliance. Sa très intéressante interview pour le site KDnuggets montre notamment que s’il promeut le Big Data en tant qu’outil statistique pour l’évaluation des politiques de développement, il n’oublie pas de questionner ses aspects politiques et éthiques (protection de la vie privée, accès aux données, anonymisation) ainsi que la validité des données recueillies : selon lui, la production de ces dernières par une certaine catégorie de personnes seulement, par exemple celles qui ont accès à Internet, introduit un biais dont les modèles prédictifs doivent impérativement tenir compte.

Ce n’est évidemment pas la première fois qu’est évoqué le recours au Big Data pour les problématiques liées au développement – l’ONU y a même dédié un programme, Global Pulse. Mais il est étonnant que le très sérieux journal Les Echos n’ait pas apporté de contrepoint à la vision de Jeffrey Sachs. Ils auraient, par exemple, pu faire appel au statisticien français Emmanuel Letouzé, fondateur du think tank Data-Pop Alliance. Sa très intéressante interview pour le site KDnuggets montre notamment que s’il promeut le Big Data en tant qu’outil statistique pour l’évaluation des politiques de développement, il n’oublie pas de questionner ses aspects politiques et éthiques (protection de la vie privée, accès aux données, anonymisation) ainsi que la validité des données recueillies : selon lui, la production de ces dernières par une certaine catégorie de personnes seulement, par exemple celles qui ont accès à Internet, introduit un biais dont les modèles prédictifs doivent impérativement tenir compte.

Au final, Les Echos passent sous silence le risque important à laisser croire que le Big Data est la solution à tous les problèmes.

Retrouvez ci-dessous notre série d’articles portant sur le Big Data, problématique qui sera au centre de l’Université d’été de la CFE-CGC Orange, qui aura lieu les 22 et 23 juin.