Avec un peu de retard, nous actualisons les graphiques qui permettent d’appréhender, de manière synthétique, les indicateurs clefs des opérateurs de télécommunications en France avec les données consolidées de l’année 2014.

Vous pouvez retrouver sur ce blog nos analyses des données 2008, 2010, 2011, 2012 et 2013.

Ces indicateurs proviennent de l’Observatoire des marchés consolidé par l’Arcep, régulateur français des télécoms, les chiffres étant tirés des séries annuelles depuis 1998, dont nous intégrons les actualisations rétroactives dans nos graphiques. Nous les complétons par l’analyse des données présentées par France Télécom-Orange dans son document de référence 2014.

Ils ne concernent que les opérateurs de télécommunications, hors activité des autres acteurs de la filière, et le marché français.

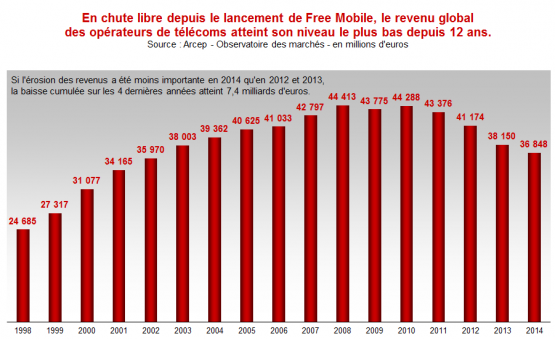

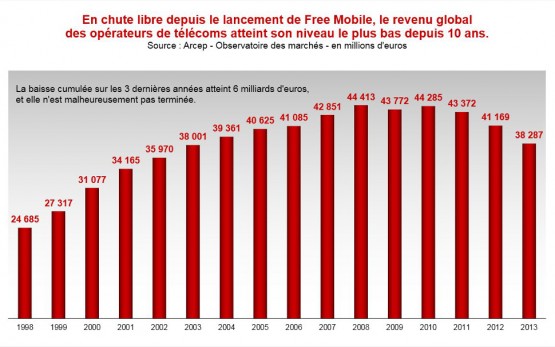

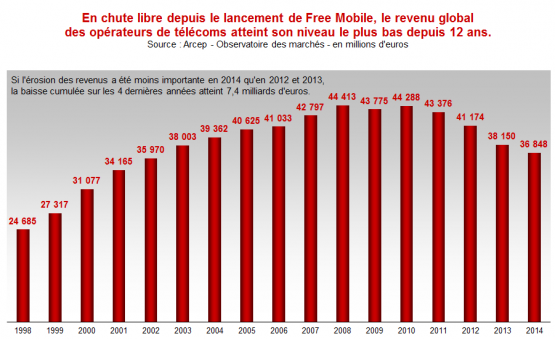

Les revenus des opérateurs atteignent leur plus bas niveau depuis 12 ans

Certes, la baisse de revenus observée par les opérateurs en 2014 (-3,4%) est moins importante que celle de 2013 (-7,3%). Toutefois, les services mobiles (-7%) continuent à tirer le marché vers le bas, alors même que le nombre d’abonnés (+2,5%) et, surtout, le trafic (+7% pour la voix, +2% pour les SMS et +97% pour la data !) ne cessent d’augmenter. De fait, l’étude de l’Arcep sur l’évolution des prix des services mobiles met en lumière une baisse moyenne de 10% en 2014, certes moins importante que celle observée en 2013 (-26%), mais qui continue d’impacter fortement les revenus d’opérateurs engagés dans la spirale du « low-cost » depuis l’arrivée de Free Mobile en 2012. En effet, si l’impact maximal a eu lieu l’année même du lancement de Free Mobile, les renouvellements de contrats qui arrivent à échéance dans les années qui suivent se font systématiquement à des conditions tarifaires en baisse… d’autant plus dans un contexte de morosité économique, alimentée par un chômage de masse qui devient, malheureusement, une constante de notre vie économique.

Appelé, fin 2014, à commenter ces chiffres et à extrapoler sur leur évolution future, Jean-Ludovic Silicani, alors Président de l’Arcep, pariait sur un accroissement des revenus des opérateurs pour 2015. Pour justifier son optimisme, il estimait que la guerre des prix arrivait à son terme et qu’une « cure d’amaigrissement » du marché avait contribué à son « assainissement ». Hélas, comme toujours, ce sont les emplois du secteur qui ont fait les frais de ce régime forcé, sacrifiés sur l’autel des politiques de rationalisation des coûts des opérateurs. Mais le régulateur n’en a cure, obnubilé par la religion de la concurrence à tout prix.

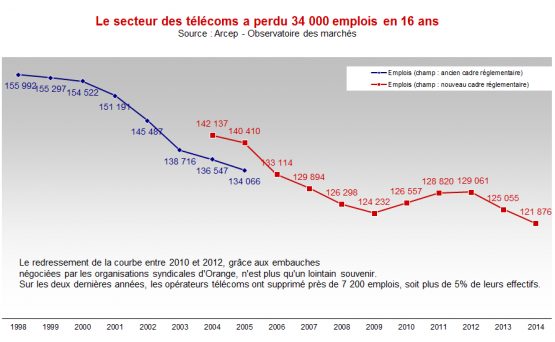

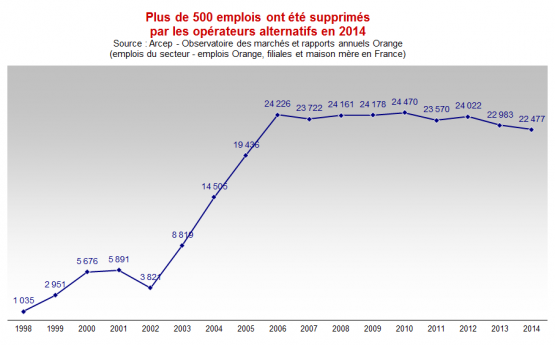

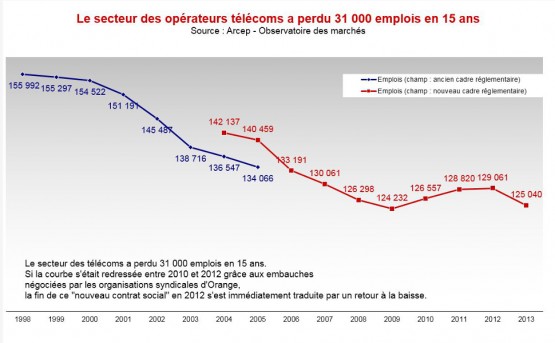

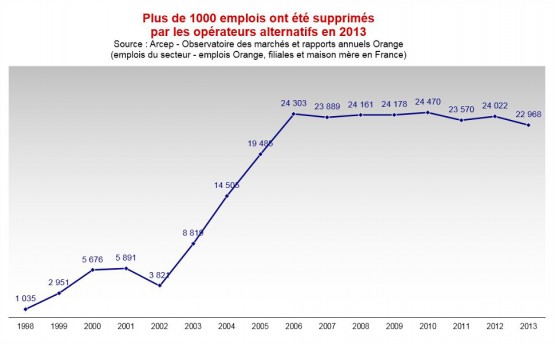

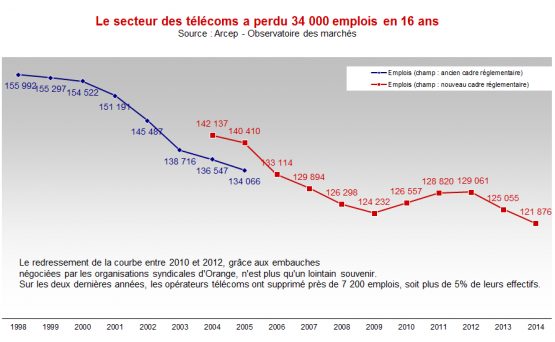

Les opérateurs poursuivent leur politique de réduction d’effectifs

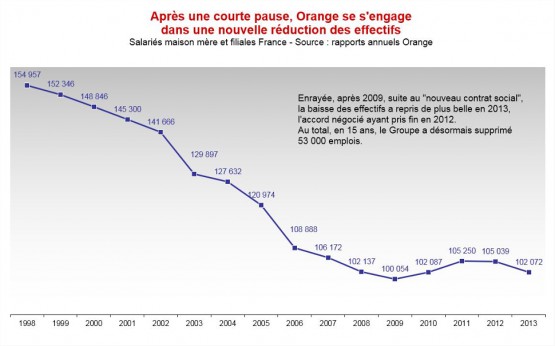

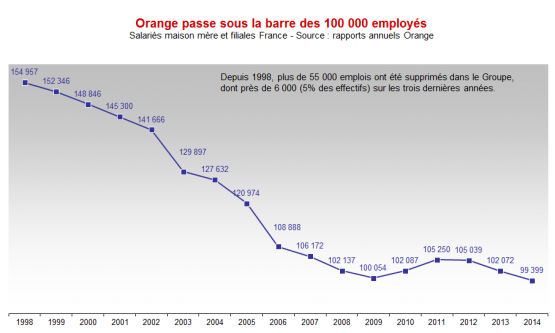

De fait, 3000 postes ont été supprimés dans le secteur des télécoms en 2014, soit une baisse des effectifs de 2,5%. De façon logique, la courbe globale du secteur suit de près les fluctuations de l’opérateur historique (qui s’est délesté de 2,6% de ses effectifs contre 2,2% pour ses concurrents), qui représente toujours 82% des effectifs du secteur. Ainsi, les 5000 emplois nets créés entre 2009 et 2012, sous l’effet du « nouveau contrat social » négocié par les organisations syndicales auprès de la direction d’Orange, ont été contrebalancés par… plus de 7000 suppressions de postes en deux ans suite à la fin de cet accord.

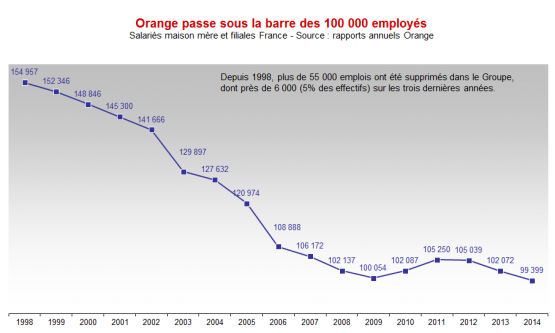

Avec près de 2700 emplois supprimés en 2014, Orange est passé sous la barre symbolique des 100 000 employés en France. La Direction de l’opérateur historique poursuit sa politique de réduction d’effectifs sans plan social, se contentant de s’appuyer sur une pyramide des âges vieillissante : en 2014, les 1600 embauches en CDI n’ont pas compensé les 3600 départs, essentiellement en retraite. Ce mouvement n’est pas près de s’inverser, le Groupe tablant sur le départ à la retraite de 30 000 salariés sur la période 2013-2020, dont une grande partie ne sera pas remplacée : l’objectif affiché est de stabiliser les effectifs autour de 66 000 à l’horizon 2020.

Au final, confronté à la pression d’un marché toujours très concurrentiel, et d’un actionnaire principal (l’État) qui réclame toujours un dividende plus élevé que l’entreprise ne peut le supporter, Orange continue à faire supporter à ses personnels l’essentiel de son effort de rationalisation des coûts, par la baisse des effectifs, mais aussi par la mise en œuvre de mesures d’économie, certes moins « drahistiques » que chez Numericable-SFR, mais qui constituent une pression quotidienne à l’impossible injonction de faire toujours plus avec toujours moins de moyens.

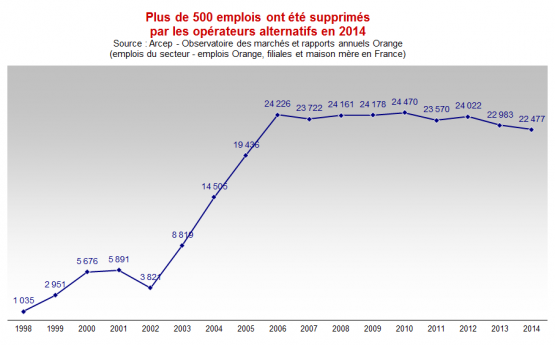

La situation n’est pas meilleure du côté des opérateurs alternatifs, qui ont vu disparaître un peu plus de 500 emplois en 2014, et aux dernières nouvelles, elle ne devrait pas s’arranger : en juin 2014, Bouygues Télécom annonçait la suppression à venir de 1500 emplois, tandis que le rachat de SFR par Numéricable menacerait à terme entre 1000 et 2000 emplois selon une estimation du Ministère de l’Économie et des Finances.

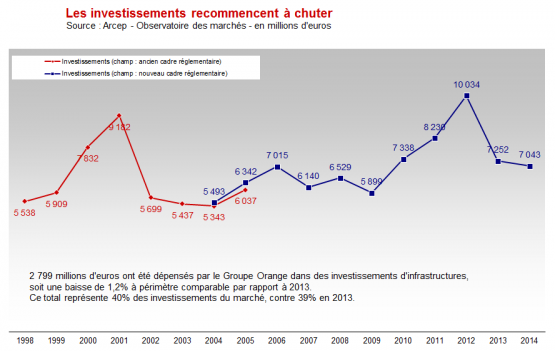

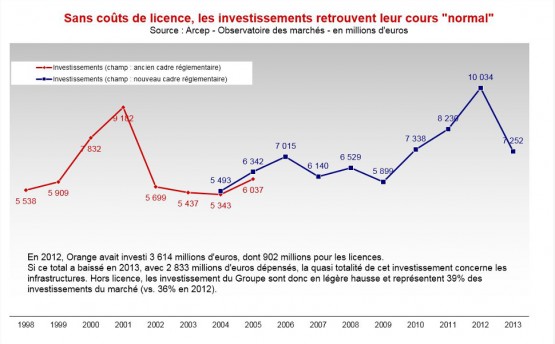

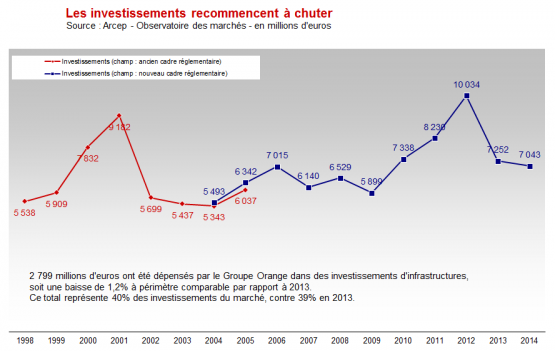

Les investissements hors achats de licences sont à leur plus bas niveau depuis 4 ans

Après les achats de licences 4G des années 2011 et 2012, les investissements ont retrouvé un niveau plus « normal » depuis 2013. En 2014, ils ont à peine dépassé la barre des 7 millions d’euros (-2,9% par rapport à 2013), et si on met de côté les rares achats de licences pendant la période, les investissements sont restés en deçà des 7 milliards d’euros, à 6 906 millions d’euros (-3,5%), pour la première fois depuis 2010.

SFR a notablement contribué à cette baisse, en diminuant ses investissements d’infrastructures de 150 millions d’euros, durant la période d’attentisme qui a précédé sa fusion avec Numericable. La politique mise en œuvre par le repreneur risque de ne pas améliorer les choses en 2015… d’autant que tous les opérateurs ont fortement investi dans l’acquisition de nouvelles licences 4G. (Au total, les lauréats devront verser à l’État une redevance fixe de 2 798 976 324 euros. Celle-ci est exigible en quatre quarts entre 2015 et 2018. Ils verseront également une redevance variable égale à 1% du chiffre d’affaires réalisé sur les fréquences concernées. Source : Arcep)

Ces chiffres ne mentionnent pas les dégâts intervenus dans le reste de la filière télécoms

Aucun acteur n’ose plus suivre en détail l’évolution de l’emploi chez l’ensemble des acteurs de la filière des télécoms en France (équipementiers, centres d’appels, réseaux de distribution spécialisés, sous-traitants en génie civil, SSII intervenant directement chez les opérateurs ou dans le domaine des services numériques…).

Les données publiées par la Fédération Française des Télécoms (enquête Arthur D.Little publiée en 2014 et en 2015), qui n’agglomèrent que les 5 premiers acteurs des activités suivantes : opérateurs télécoms, équipementiers réseaux, fabricants de terminaux (qui n’engendrent que très peu d’emplois directs), fournisseurs de contenus et acteurs internet OTT, montrent cependant une très nette baisse de l’emploi :

- 2012 : 170 000 emplois

- 2013 : 159 000 emplois

- 2014 : 156 000 emplois

14 000 emplois perdus en 3 ans sur ce périmètre, dont la moitié chez les opérateurs de réseaux, et sans compter tous les autres sous-traitants du secteur, dont certains ne font plus parler d’eux… ayant purement et simplement disparu du paysage, c’est énorme pour un secteur unanimement reconnu comme l’un des principaux vecteurs de croissance pour l’économie occidentale.

Alors que « l’uberisation » constitue la nouvelle perspective de l’économie numérique (ou portée par le numérique), et sachant quels dégâts elle produit sur la création de valeur et d’emplois stables, il est plus que temps que nos dirigeants se retroussent les manches pour créer les conditions d’une croissance riche en emplois de qualité !

Le passage d’une année à une autre est souvent l’occasion des bilans. Durant la période des fêtes, L’Usine Digitale nous a proposé une sélection de 12 romans, essais, chroniques, etc. parus en 2015, qui apportent des éclairages particuliers sur la transformation numérique de nos vies.

Le passage d’une année à une autre est souvent l’occasion des bilans. Durant la période des fêtes, L’Usine Digitale nous a proposé une sélection de 12 romans, essais, chroniques, etc. parus en 2015, qui apportent des éclairages particuliers sur la transformation numérique de nos vies.